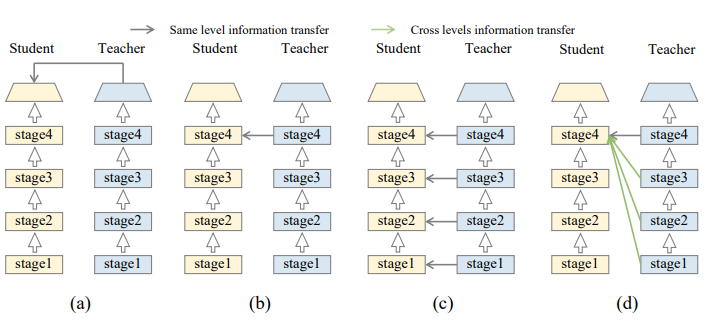

논문 제목 : Distilling Knowledge via Knowledge Review 컨퍼런스 : 2021 CVPR 저자 : Pengguang Chen et al 대학 : The Chinese Univ. of HongKong 영단어 negligible : 너무 작아서 신경쓰지 않아도될 것 intriguingly : interestingly 와 같은 의미로 흥미롭게도 consecutive : 연속적인 초록 지금까지는 feature transformation 및 loss function에 초점을 맞췄다면, 본 논문은 connection path cross levels의 factor에 대해 연구하려고 함. KD의 첫걸음으로 cross-stage connection path가 제안됨. 우리의 새로운 revi..